|

| De interés especial |

C. Redondo Figuero

Pediatra. Profesor Asociado de Pediatría. Universidad de Cantabria. Presidente del Comité Ético

de Investigación Clínica de Cantabria. Centro de Salud Vargas. Santander, Cantabria

| En esta nueva sección se van a presentar los capítulos del libro “Manual de Iniciación a la Investigación en Pediatría de Atención Primaria” recientemente editado por la SEPEAP. Consideramos esencial potenciar y desarrollar los conocimientos, habilidades y actitudes de los pediatras de Atención Primaria en el campo de la investigación, que contribuirá a mejorar el cuidado de nuestros pacientes. Os animamos a que nos enviéis vuestros trabajos de investigación, que tras la evaluación por el Consejo editorial, podrán ser publicados en la revista. ¡Esperamos vuestras aportaciones! |

Aspectos metodológicos básicos en investigación

Estudios en investigación aplicada

Investigar es intentar conocer la verdad de las cosas. En el ámbito sanitario la investigación pretende identificar factores que se asocien con la enfermedad para así poder actuar sobre ellos y, consecuentemente, mejorar la salud de la población. La investigación es un proceso inductivo-deductivo cuya base es la existencia de una pregunta que se hace el investigador, es decir, una duda interesante, novedosa, ética, relevante y factible que ha de resolver aplicando el Método Científico (ver Tema 1).

El investigador puede aproximarse a la realidad observando lo que sucede (estudios observacionales) o manipulando y controlando la exposición para ver qué sucede (estudios experimentales). Cuanto más controle mayor fortaleza tendrán las conclusiones y viceversa, cuanto menos intervenga mayores posibilidades de sesgo tendrá el estudio.

El proceso de investigación comienza cuando un investigador se plantea un pregunta que debe ser respondida y él no conoce la respuesta. Entonces el investigador deberá planificar una investigación. Esta planificación supone pasar por cuatro fases bien definidas, las tres primeras para decidir el tipo de estudio (Tabla I) y la cuarta para delimitar los componentes del estudio elegido (Tabla II).

En primer lugar tiene que establecer el marco teórico en el que encuadrar su cuestión; es decir, situar la pregunta en el Cuerpo de Conocimientos Científicos existente: ¿qué es lo que se conoce?, ¿qué falta por conocer?, ¿qué es susceptible de ser intervenido?

En segundo lugar formula su hipótesis y, de acuerdo a ésta, plantea los objetivos. Una hipótesis (H) es una declaración que realiza el investigador proponiendo la relación que cree que existe entre el factor (o factores) y el desenlace. Es pues, un intento de responder a la pregunta de investigación. Hay dos tipos de hipótesis, la nula (no hay diferencia entre los dos grupos que se comparan) y la alternativa (hay diferencia y además en un determinado sentido). De acuerdo a la hipótesis, que suele plantearse en su forma alternativa, se deciden los objetivos, es decir, la hipótesis se traslada a variables operativas que se pueden y deben medir.

En tercer lugar decide cómo conseguir estos objetivos. Se debe plantear qué tipo de estudio deberá emprender para llegar a responder su pregunta. Es decir, deberá elegir uno de entre los muchos diseños que existen. En esta decisión influirán la validez del diseño y los recursos disponibles (tiempo, información, población disponible, aspectos éticos, financiación económica, etc.). Fundamentalmente, debe decidir si decide manipular o controlar el factor de estudio (estudios experimentales) o simplemente desea observar lo que sucede en la naturaleza (estudios observacionales). La decisión es muy importante, porque influirá enormemente en el diseño, en los posibles sesgos que deberá intentar controlar (muchos en los estudios observacionales y pocos en los experimentales) y en la extrapolación de las conclusiones (los estudios experimentales, aunque tienen pocos sesgos y gran potencia estadística, a veces no son tan fácilmente generalizables, porque la población general no siempre está bien representada en los sujetos estudiados tras unas rigurosas condiciones de inclusión).

Y, en último lugar, deberá realizar la planificación operativa del estudio, para lo cual habrá que definir la población diana (población a la que se pretenden extrapolar los resultados del estudio), población accesible (en base a consideraciones prácticas de accesibilidad), muestra (fracción de la población accesible que se selecciona para el estudio). También habrá que definir qué variables se van a medir, cómo se van a recoger los datos y cómo se analizarán posteriormente.

Siempre es importante el apartado de organización (cronograma y presupuestos) junto con el estudio de las cuestiones éticas y legales que se puedan plantear (Tabla II).

En todos los estudios se pretende encontrar una asociación entre una exposición (factor) y una enfermedad (efecto). Esta asociación podrá ser nula (no hay relación estadísticamente significativa entre factor y efecto) o por el contrario puede encontrarse una asociación, positiva o negativa, entre el factor y el efecto. Una vez encontrada la asociación habrá que darle un sentido de causalidad (si se puede, siguiendo los criterios establecidos por Sir Austin Bradford Hill (Tabla III).

Clasificación de los estudios

Cuando un investigador decide responder a una pregunta de investigación que se ha planteado respecto de una determinada enfermedad, lo primero que suele plantearse es con qué frecuencia se manifiesta dicha enfermedad, preguntándose por sus características de tiempo, lugar y persona. Deberá, por tanto, realizar un estudio descriptivo, utilizando como unidad de estudio la comunidad (estudios ecológico) o el individuo describiendo los casos que conoce (estudio de serie de casos). Pero probablemente decida avanzar más y pretenda analizar si existe una asociación entre uno o más factores y la enfermedad que le preocupa (estudios analíticos). Esta asociación la puede estudiar controlando la asignación del factor sometido a estudio (estudio experimental) o que simplemente observando lo que sucede, sin que él manipule el factor de estudio (estudio observacional).

Estudios experimentales

La característica del estudio experimental es que el investigador asigna la exposición al factor. Es decir el investigador no es un mero observador de lo que sucede, sino que él manipula las condiciones naturales decidiendo qué grupo de individuos debe exponerse al factor y cuál no. Sigue a los individuos en el tiempo y observa qué es lo que sucede. Su clasificación depende de distintas consideraciones: 1) sujetos enfermos (ensayo clínico) o sanos (ensayo comunitario); 2) asignación al azar (ensayo experimental puro) o sin él (estudio cuasi-experimental); y 3) con grupo control (estudio experimental con control) o sin el (estudio experimental sin control).

El ensayo clínico

Según Bradford Hill un ensayo clínico es un experimento cuidadosa y éticamente diseñado para responder a preguntas concretas formuladas previamente. Estas preguntas tienen que ver con la evaluación de la utilidad de procedimientos diagnósticos, terapéuticos y profilácticos en el ser humano.

La mayor ventaja del ensayo clínico es demostrar causalidad, ya que la asignación aleatoria elimina la influencia de las variables de confusión y el cegamiento que los efectos observados sean debidos a sesgos o a otros tratamientos.

Tras seleccionar a un grupo de sujetos que cumplen unos criterios de inclusión (características clínicas y sociodemográficas de los enfermos) se eliminan a los que pueden presentar alguna contraindicación para someterse a la intervención (criterios de exclusión). Se efectúa una medición de variables basales, para conocer las características de los sujetos (también sirve de ayuda para mejorar la elegibilidad); posteriormente se aleatorizan, es decir se reparten en dos o más grupos de tratamiento, se les sigue durante un periodo determinado (y lógico como para que se produzca un efecto) y posteriormente se analizan las diferencias de presentación del efecto en cada uno de los grupos.

Es más fácil en estos estudios evitar los sesgos que en los estudios de casos y controles, pero pueden existir: a) sesgo de selección, por diferencias sistemáticas en los dos grupos de comparación, aunque esto se puede evitar ocultando la secuencia de aleatorización; b) sesgo de cointervención, por diferencias sistemáticas en los cuidados recibidos por los dos grupos (independientemente de la intervención), aunque esto se puede evitar mediante el enmascaramiento de la intervención; c) sesgo de atrición, por diferencias sistemáticas en los abandonos, o en el cumplimiento terapéutico, esto se debe controlar mediante el análisis de resultados “por intención de tratar”; y d) sesgo de información, por diferencias sistemáticas en la evaluación de las variables de resultado entre los grupos de comparación, esto se evita mediante el enmascaramiento de la intervención y en la fase de análisis.

Estudios experimentales en la comunidad

Son ensayos clínicos en los que las unidades de intervención son comunidades y no individuos.

Se utilizan para evaluar intervenciones que tienen sentido comunitario poblacional, como la fluoración de las aguas para evitar las caries, intervenciones de promoción de la salud en trabajadores de toda una empresa, etc.).

Estudios cuasi-experimentales

La principal característica de estos estudios es que no hay asignación aleatoria de los individuos, de ahí que estén sometidos a presencia de errores. En ocasiones se trata de controles históricos, es decir se suelen comparar resultados tras la puesta en marcha de una intervención con los resultados previos. Con frecuencia hay errores por un efecto periodo y factores de confusión, aunque un RR >5 es bastante improbable que pueda ser completamente explicado por uno o varios sesgos.

Estudios observacionales

En ocasiones existen limitaciones éticas que impiden la manipulación por el investigador, entonces éste debe comportarse como un mero observador, ya que no controla la exposición al factor, sino que ya le viene dada. De ahí que la validez del estudio sea menor que la de los diseños experimentales.

Estudios transversales

Tienen como fin estimar la frecuencia del factor y la enfermedad en una población en un momento determinado. Por eso se llaman también estudios de prevalencia. Como ofrecen una “foto” de la realidad son muy utilizados en planificación sanitaria.

Con frecuencia se quieren extraer conclusiones de asociación causal (estudios transversales analíticos), pero se ha de tener en cuenta la dificultad existente de medir causa y efecto al mismo tiempo ¿la causa produce el efecto o al revés? Por otro lado, existen sesgos cuando la exposición se relaciona con la duración de la enfermedad, porque puede haber infra o suprarrepresentación de los casos si la enfermedad dura poco o mucho.

Estudios de casos y controles

De una determinada población se seleccionan dos grupos, unos con determinada enfermedad (casos) y otros sin ella (controles). Se les pregunta retrospectivamente sobre una determinada exposición para valorar si la exposición al factor es más frecuente en un grupo que en otro.

Los casos deben estar perfectamente definidos y con unos criterios muy estrictos. Los controles, que se van a utilizar para estimar la prevalencia de exposición al factor en la población de la que provienen los casos, pueden seleccionarse tanto de un medio hospitalario como de la población general, pero su selección no debe verse influida por el grado de exposición al factor de estudio.

Este diseño se utiliza mucho para estudiar enfermedades poco frecuentes o de largo periodo de exposición. Pero el mayor problema que tienen es la presencia de sesgos.

Estudios de cohortes

Tras seleccionar dos o más cohortes o grupos de personas en base a su exposición al factor, se las sigue durante un determinado periodo de tiempo y se observan los casos que aparecen en cada uno de los grupos.

Son los diseños más adecuados para describir la incidencia y la evolución de la enfermedad.

Estudios ecológicos

Son estudios no experimentales en los que la unidad de observación es el grupo. Debe haber información sobre la exposición y enfermedad en cada grupo. Generalmente lo que se mide es la mortalidad o la incidencia de determinada enfermedad en los grupos que se comparan en base a los diferentes grados de exposición a un determinado factor. Por ejemplo, mortalidad por cáncer esofágico en las distintas comunidades españolas según el consumo de alcohol.

La principal limitación de este tipo de estudios es la falacia ecológica, que consiste en inferir asociaciones individuales basadas en observaciones grupales. Existen otras limitaciones como son la dificultad para controlar los factores de confusión, la ambigüedad temporal y la colinealidad entre variables.

Revisiones sistemáticas

La revisión sistemática identifica estudios sobre un tema, analiza sus resultados y extrae una conclusión sobre los hallazgos. Es una buena oportunidad para el investigador novel, ya que no suele requerir importantes fuentes de financiación, y un vez realizado le ayudan a convertirse en un experto en el tema.

Exigen para su realización de una sistemática muy precisa (ver la siguiente lista).

1. Pregunta de investigación claramente formulada.

2. Identificación comprensiva y no sesgada de estudios de calidad finalizados.

3. Definición de criterios de inclusión y exclusión.

4. Resumen uniforme y sin sesgos de las características y hallazgos de cada estudio.

5. Presentación clara y uniforme de los datos de cada estudio.

6. Cálculo de los estimados de efecto e intervalos de confianza basados en los hallazgos de todos los estudios (si es pertinente).

7. Investigación de la heterogeneidad de los hallazgos de los estudios individuales.

8. Investigación del posible sesgo de publicación.

9. Análisis de sensibilidad y por subgrupos.

En todos los estudios hay un error aleatorio que hace que los resultados del estudio no coincidan con la verdad en la población, aunque se puede disminuir si se aumenta el tamaño muestral (TM); de manera que, conforme aumenta el TM más precisos o fiables serán los resultados, es decir, más estrecho será su intervalo de confianza (IC). Más nos preocupa el sesgo o error sistemático, que no se reduce aumentando el TM y que disminuye la validez del estudio. Este tipo de error es el que nos debe preocupar. Hemos de hacer todos los esfuerzos posibles para disminuir al máximo los posibles sesgos que siempre afectan a los estudios (más a los observacionales que a los estudios experimentales).

Hay muchos tipos de sesgos y muchas veces aparecen combinados y difíciles de separar. Se suelen clasificar en: 1) sesgo de selección, cuando se seleccionan inadecuadamente los individuos de estudio, por eso en todo estudio es obligado describir la características de los grupos para ver que no hay diferencias; 2) sesgo de información, cuando durante el estudio se obtiene diferente información de las personas por utilizar aparatos mal calibrados, por utilizar variables autodeclaradas en vez de medidas, por diferencias en la memoria de ciertos hechos, etc.; y 3) sesgo de confusión, se da por la existencia de una variable externa que distorsiona la relación exposición-enfermedad y esto sucede cuando el factor de confusión se asocia con la exposición, se asocia con la enfermedad y no es un paso intermedio entre la exposición y la enfermedad. La confusión afecta a la validez del estudio, por lo que siempre hay que buscarla para controlarla, ya sea en la fase de diseño mediante la aleatorización, o en la fase de análisis mediante la estratificación o mediante el análisis multivariable.

Tamaño de la muestra y muestreo

Una de las preguntas más importantes e iniciales que se plantea el investigador cuando va a realizar un estudio es, ¿cuál debe ser el tamaño mínimo de la muestra para lograr los objetivos del estudio? Esta pregunta es una de las más difíciles de responder, porque cuanto mayor sea el tamaño de la muestra (TM), más precisas serán las estimaciones de los parámetros y de sus diferencias, pero más caras en tiempo y en dinero. Siempre supone un análisis coste-beneficio. En ocasiones, el investigador no tendrá limitaciones en cuanto a recursos y presupuesto, pero deberá ponderar entre los beneficios que suponen el aumentar el TM frente a los costes que implica la recogida de esos datos. En otras ocasiones, el tiempo o los recursos financieros disponibles marcan un límite infranqueable para el investigador. Por otro lado, un estudio realizado con el mayor rigor posible será incapaz de dar respuesta a la pregunta de investigación si el tamaño de la muestra es demasiado pequeño. Así pues, la respuesta a ¿cuántas observaciones debe efectuar? informará al investigador sobre si podrá o no realizar dicho estudio.

Los cálculos del TM son únicamente una guía útil para el investigador: por un lado dan una impresión engañosa de objetividad estadística, pero por otro lado se sabe que son tan exactos como los datos y estimaciones en las que se basan. Es decir, el cálculo del TM es una manera científica de hacer un cálculo aproximado, siempre en la fase de planificación del estudio.

Debido a que todos los estudios en los que participan personas plantean un conjunto de cuestiones éticas, se han desarrollado unos principios éticos que deben tenerse en consideración. No es ético realizar un estudio con un TM insuficiente para asegurar una potencia adecuada. Tampoco parece ético someter a más sujetos de los necesarios a los riesgos y molestias de un estudio (toma de drogas con posibles efectos secundarios, pinchazos, ausencias en el trabajo para acudir a las citas, gastos de desplazamiento, etc.) si con ello no se consigue un aumento significativo de la precisión o de la potencia del estudio. Además, siempre hay errores que se magnifican (errores en las mediciones, en la recogida de los datos, etc.) cuando se aumenta el TM.

La respuesta a esta pregunta inicial en la planificación del estudio supone, de alguna manera, relacionar la precisión con el TM. De acuerdo con Jenicek, el TM debe ser el tamaño justo, es decir, ni pocos (pues el estudio no demostraría nada), ni muchos (ya que incluso los riesgos relativos pequeños serían significativos y el estudio no demostraría casi nada. Como es lógico, los estudios con un TM reducido solamente detectarán riesgos considerables, mientras que los de un TM considerable permitirán evaluar asociaciones sutiles. Aumentar la precisión supone disminuir el error aleatorio, es decir, el debido al azar. Esto se puede lograr de dos formas: a) aumentando el TM; y b) modificando el diseño del estudio para aumentar la eficiencia con la que se obtiene la información en los sujetos sometidos a estudio.

Para entender el cálculo del tamaño muestral (TM) hay que comprender el fundamento del intervalo de confianza. El intervalo de confianza está determinado por tres factores: a) la confianza deseada (1-a); b) la variabilidad de la muestra (se mide con la desviación estándar); y c) el tamaño de la muestra. Así la precisión de una media viene determinada por la ecuación (1) y la precisión de una proporción mediante la ecuación (2):

En general para calcular el tamaño muestral se necesita:

a) Magnitud del efecto. Es la diferencia que se quiere buscar. Cuanto más grande sea, menor número de sujetos se necesitará.

b) Error alfa. Es el riesgo de que se considere efectivo un tratamiento que en realidad no lo sea.

c) Error beta. Es la probabilidad de no detectar una diferencia realmente existente. Su complementario, 1-b, es la potencia estadística, es decir, la probabilidad de que un ensayo detecte una diferencia cuando en realidad existe. Aunque habitualmente se toma el valor 0,8, cuanto más alta sea mejor.

La cuestión del TM de un estudio no es sólo un cálculo con una fórmula matemática, sino que es un juicio de valor del investigador, por lo que su experiencia, intuición y discernimiento tendrán la última palabra.

Podemos distinguir dos tipos fundamentales de cálculo del TM: 1) estimación de parámetros; y 2) contraste de hipótesis.

Estimación de parámetros

Se utiliza habitualmente para estimar una proporción y una media (con menos frecuencia). Se han de considerar dos posibles situaciones: a) cuando el muestreo es con reemplazo (se saca una bola de la urna, se anotan sus características y se vuelve a introducir en la urna, de forma que siempre hay la misma probabilidad de una determinada característica); en otras ocasiones la población es tan grande (infinita) que aunque no se reintroduzca la bola en la urna la probabilidad de una determinada característica sigue siendo la misma (ecuación 3 para una proporción y ecuación 4 para una media); y b) muestreo sin reemplazo en una población finita, donde conforme se van extrayendo bolas la probabilidad va cambiando, de ahí que haya que introducir un factor de corrección (ya no es probabilidad binomial sino hipergeométrica); son las ecuaciones (5) para una proporción y (6) para una media.

Contraste de hipótesis

El tamaño de la muestra necesario para contrastar dos proporciones independientes se deduce de la especificación de los errores a y b, correspondientes a las hipótesis nula y alternativa, respectivamente, sobre la verdadera diferencia en la proporción de aciertos en la población. Suponiendo que no hubiera diferencia alguna entre las dos proporciones, a es la probabilidad de declarar falsamente que las dos proporciones son diferentes; y si las proporciones fuesen diferentes, 1-b es la probabilidad de declarar correctamente que las dos proporciones son diferentes. Respecto a a, cuando la prueba es bilateral se utiliza z1-a/2, mientras que cuando es unilateral se utiliza z1-a. La fórmula que se utiliza es (7), siendo n0 = r n1, o sea que r=1 cuando los grupos son de igual tamaño; y P=(P0+P1)/2.

Suponga que se va a realizar un ensayo clínico unicéntrico simple ciego y aleatorizado de comparación de la eficacia erradicadora de primera línea frente al Helicobacter pylori de dos terapias: la convencional CAO (claritromicina, amoxicilina y omeprazol) y la novedosa LAO (levofloxacino, amoxicilina y omeprazol), administradas durante 10 días, cuya eficacia según la literatura es del 75 y 90%, respectivamente, los investigadores desean calcular el TM, de cada uno de los dos grupos de similar tamaño, con un riesgo a = 0;05 y riesgo b = 0;20. Aplicando la fórmula (7) obtendrá que se necesitan 138 sujetos en cada uno de los dos grupos, por tanto, un total de 276 sujetos.

El tamaño muestral necesario para comparar dos medias se calcula con la fórmula (8) que precisa conocer cuál es el tamaño que se considera clínicamente relevante (d1-d0), la variancia común (s2), los valores a y b que tienen la misma consideración que en el apartado anterior de comparación de dos proporciones.

Supongamos que desea realizar un estudio para valorar el efecto de determinado medicamento sobre el volumen espiratorio forzado en adolescentes de 13 a 17 años de edad. Por estudios previos se conoce que la desviación estándar de esta variable en este grupo de edad es de 0,5 L. ¿Qué tamaño muestral será necesario, con una potencia del 80% y un nivel del confianza del 95%, para detectar un cambio de, al menos, 0,25 L (que considera como clínicamente relevante)? Calcule el TM suponiendo que los dos grupos son de igual tamaño y que no va a haber pérdidas. Aplicando la fórmula anterior obtendrá que se necesitan dos grupos de 63 sujetos, es decir, un total de 126 adolescentes.

En investigación se dan muchas otras situaciones, por ejemplo, comparar dos proporciones o dos medias en muestras pareadas, regresión lineal, regresión logística, análisis de supervivencia, etc. Para cada una de estas situaciones hay fórmulas específicas, que no se presenta aquí por la limitación de espacio del capítulo y porque estamos en un nivel introductorio. Cuando le surja la necesidad consulte buenos libros y, sobre todo, consulte con un estadístico.

Definición de variables

Variable es un aspecto concreto que se mide en los sujetos del estudio. Toma diferentes valores en cada sujeto (de ahí el nombre de variable). Puede variar poco (por ejemplo, el sexo, con dos posibles valores: hombre o mujer) o mucho (p. ej.: el peso, con infinitos posibles valores teóricos). Las variables son muy importantes en investigación ya que ésta consiste en investigar la asociación entre unas variables (factores) y otras (efecto).

Tipos de variables

Según se empleen distintos criterios se pueden clasificar en diferentes tipos pero, en aras de la brevedad y comprensión, se puede decir que si lo que se está considerando se puede medir con números, las variables son numéricas o cuantitativas, y si no son cualitativas.

• Variables cualitativas. Valoran una condición o característica que no se puede medir con números. Se distinguen dos tipos: 1) binarias o dicotómicas, cuando la característica estudiada solo presenta dos categorías, p. ej.: sexo (hombre/mujer), enfermedad (enfermo/sano), vida (vivo/muerto), etc.; 2) multicotómicas, cuando presenta más de dos categorías sin que haya ninguna significación de valor entre éstas; p. ej.: grupo sanguíneo (A, B, AB, O), color del pelo (rubio/castaño/moreno/pelirrojo/etc.); 3) multicotómicas ordenadas (o simplemente ordenadas) las categorías son diferentes y además una categoría es valorada de forma diferente respecto a otra y, por tanto, se pueden ordenar en base a esta valoración, p. ej.: respuesta al tratamiento (muy mala/mala/regular/buena/muy buena), nivel educativo (analfabeto/estudios primarios/secundarios/universitarios), clase social, etc. En este tipo de variables aunque no se sabe si la distancia entre las categorías es igual o no (p. ej.: entre mala/regular no sabemos si hay la misma distancia que entre buena/muy buena), sí se sabe cuál es mejor y cuál es peor.

• Variables cuantitativas. Lo que valoran se puede medir con números. Hay dos tipos: 1) discretas, cuando entre un valor mínimo y uno máximo sólo hay determinados posibles valores, p. ej.: el número de hijos de una mujer (sólo es posible observar un de estos valores: 0, 1, 2, 3…, pero no es posible, por ejemplo, 1,72 hijos); y 2) continuas, cuando entre un mínimo y un máximo es posible encontrar infinitos valores, p. ej.: el peso, la talla, etc., aunque en la práctica, debido a la precisión de los aparatos, los resultados se obtienen con un determinado número de decimales y, por tanto, estas variables continuas parecen discretas, cuando en realidad son variables continuas.

La información que contiene las variables es mayor cuanto más se avanza en el tipo de variables: dicotómicas < multicotómicas < ordenadas < discretas < continuas. De ahí que, siempre que se pueda medir una determinada característica con diferentes variables será preferible utilizar la que más información tenga; por tanto, a la hora de preguntar por el hábito tabáquico, más que preguntar si es fumador (sí/no) o no fumador (fuma poco/fuma mucho) o cuánto fuma (nada/1-9/10-20/20-40/más de 40 cigarrillos) es mucho mejor preguntar por el número de cigarrillos que fuma al día (0, 1, 2…). Esta última pregunta contiene muchas más información, y siempre se puede reconvertir en una de las otras si es que interesa en alguna fase del análisis, pero si se ha recogido como variable binaria nunca se podrá reconvertir en el sentido contrario. Este es un error que se observa con frecuencia en el diseño de encuestas.

Otra clasificación de las variables es según el papel que desempeñan en la investigación: 1) independientes, representan la característica de la enfermedad o del resultado de una intervención, de una prueba, etc.; y 2) dependientes, representan los posibles factores o características que pueden estar asociados a la enfermedad o ser causa de ella, p. ej.: edad, sexo, peso, talla, hábito tabáquico, nivel educativo, etc.

Características de las variables

En el diseño de una investigación es muy importante que el investigador defina todas las características de las variables que va a utilizar:

• Nombre. Es un nombre corto que le recuerda al investigador el significado. Por ejemplo IMC (índice de masa corporal), Fnac (fecha de nacimiento), Fenc (fecha de la encuesta), Ptri (pliegue tricipital), etc.

• Etiqueta. Es un nombre largo que define perfectamente el significado de la variable. En él se debe incluir las unidades de medidas; por ejemplo, para la variable Glup la etiqueta podría ser “Glucemia postprandial (mg/dl)”.

• Formato. Espacio reservado para almacenar la variable, el número máximo de caracteres si es cualitativa y el espacio para almacenar los valores (incluidos los decimales) si en cuantitativa.

• Tipo. Cualitativa (binaria, multicotómica u ordinal) o numérica (discreta o continua):

– Si cualitativa: categorías y codificación empleada.

– Si numérica: unidades de medida (si es que las tiene), por ejemplo mg/dl, kg, cm, etc.

• Rango admisible (mínimo-máximo) para evitar introducir valores extremos erróneos.

Todo este trabajo que puede parecer tedioso, proporciona al investigador múltiples ventajas: a) tiene una idea más precisa de los datos; b) le ayuda a preparar mecanismos que impiden la introducción de datos erróneos; c) ahorra tiempo en depuración; y d) ayuda a evitar el síndrome GIGO.

En conclusión, es muy importante que el investigador dedique un tiempo a preparar bien su base de datos, definiendo perfectamente las variables y sus características.

Cuestionarios

Un cuestionario es un instrumento destinado a recoger información. Como cualquier otro instrumento de medida (báscula, impedanciómetro, técnica de laboratorio, etc.) tiene sus características y propiedades, que el investigador debe conocer. Por supuesto, siempre hay que utilizar el mejor instrumento de medida, que referido a los cuestionarios es el que esté bien diseñado y validado.

Hay dos tipos de cuestionarios: 1) las entrevistas personales; y 2) los cuestionarios autoadministrados. Ambos tiene sus ventajas e inconvenientes y ambos están sometidos a la posibilidad de errores.

Las entrevistas: 1) son caras; 2) están sometidas a la influencia que ejerce el entrevistador sobre la persona que responde (sesgo del entrevistador); 3) tienen menor tasa de rechazo y al hacerse delante de otra persona se suele responder más; 4) el entrevistador puede clarificas las dudas que se presentan; y 5) se controla mejor que se responda a todas las preguntas.

Los cuestionarios autoadministrados: 1) son más baratos; 2) exigen respuestas estandarizadas; 3) tienen mayor tasa de rechazo; 4) se contestan mejor porque el entrevistado no se siente presionado; 5) no se les pueden clarificar las dudas, por lo que la tasa de respuesta completa es menor; y 6) no hay control sobre su cumplimentación.

Si un cuestionario está ya validado, es el que se debe utilizar. De lo contrario antes de utilizar uno de diseño propio deberá validarlo. Un cuestionario validado es aquel que ha demostrado que mide lo que debe medir. Por lo que, si pretende validar un cuestionario, deberá diseñar un estudio a tal efecto. ¡No pierda el tiempo!, ¡utilice un cuestionario validado!

Cuando decida construir un cuestionario, deberá tener en consideración los siguientes aspectos: 1) las preguntas deben ser cerradas, es decir, deberán estar explicitadas todas las posibles respuestas. Las preguntas abiertas son difíciles de codificar y de analizar, consumen más tiempo y, a veces, los sujetos dejan de contestar; 2) defina previamente los aspectos que quiere abarcar y plasme las preguntas siguiendo un orden lógico; 3) evite información redundante, para lo cual deberá hacer un pilotaje; 4) elabore preguntas con respuestas mutuamente excluyentes para que el entrevistado elija solo una de ellas; 5) cuando elabore una pregunta en que se pueda elegir más de una opción, deberá permitir que en cada una de las opciones el entrevistado pueda marcar “sí”, “no” o “no lo sé”; 6) redacte las preguntas con claridad, utilizando palabras sencillas, evitando los estereotipos, las preguntas dobles y las palabras que tengan “carga”; 7) defina adecuadamente el marco temporal que está estudiando, porque hay aspectos que cambian en el tiempo, por ejemplo determinados hábitos; 8) utilice siempre los mismos códigos, por ejemplo, el 0 para el “no” y el 1 para el “sí”; 9) cuando quiera valorar actitudes o conductas utilice escalas aditivas tipo Likert, en las que el sujeto deberá elegir entre varias opciones ordenadas (por ejemplo: “totalmente en desacuerdo”, “en desacuerdo”, “neutro”, “de acuerdo”, “totalmente de acuerdo”); 10) cuando quiera respuestas que midan la consistencia deberá utilizar escalas acumulativas de Guttman, en las que se plantea una pregunta con varias opciones (cada una con un mayor grado de asociación entre el factor y el efecto) que deben ser valoradas como si está de acuerdo o no. Y se valora como el número de supuestos con los que está de acuerdo. Si el individuo es coherente y está de acuerdo hasta un determinado nivel es de esperar que también esté de acuerdo en los niveles inferiores; 11) si puede, utilice una escala visual para aquellas preguntas que pueda. Se trata de una línea de 10 cm de longitud, con el 0 como nada (por ejemplo, nada de dolor, en total desacuerdo con la imagen corporal, etc.) y el 10 como todo (por ejemplo, dolor insoportable, totalmente satisfecho con la imagen corporal, etc.). Este tipo de preguntas se valoran midiendo la distancia desde el extremo izquierdo (el 0) hasta la marca que ha trazado el sujeto y se tratan como una variable cuantitativa continua; y 12) evite el doble concepto en la pregunta, ya que en realidad son dos preguntas y el sujeto no sabe qué responder. Por ejemplo, cuando pregunta “Cuando su hijo tiene fiebre, ¿le trata con ibuprofeno o paracetamol? (responda sí o no)” el entrevistado no sabe si se le está preguntando por el ibuprofeno, por el paracetamol o por los dos. Desglose esta pregunta en dos y verá como supera el escollo.

Finalmente, antes de utilizar masivamente el cuestionario efectúe varios pilotajes y corrija tras cada uno de ellos. Incluso utilizando cuestionarios validados deberá realizar una prueba piloto para ver qué tal va (cuando queremos comprar un coche de un modelo y marca acreditados también queremos “probar antes de pagar”).

Cuestiones éticas

Los aspectos legales y éticos son tratados ampliamente en los capítulos 3 y 4. A ellos debe remitirse el lector. Aquí solamente comentaremos que en todo proyecto de investigación este aspecto ético nunca puede olvidarse. Las personas sobre las que se investiga tienen sus derechos que siempre deben ser respetados. Entre otros los de autonomía, el derecho a ser informado antes de ser incluido en el estudio, el respeto a la confidencialidad de los datos (obligación de cumplir la Ley de Protección de Datos de Carácter Personal) y el poder retirarse del estudio sin tener que dar ninguna explicación. Todo proyecto de investigación conviene que sea evaluado y aprobado por un Comité Ético de Investigación Clínica (CEIC). Esto le permitirá mejorar su investigación, ya que estos CEIC no solo velan por los aspectos éticos, sino también por los metodológicos. Su aprobación supone que ya ha pasado un primer filtro en la calidad del estudio, además muchas revistas de prestigio exigen que la investigación haya sido aprobada por un CEIC para poder publicar los resultados del estudio.

Mi consejo es que se anime a presentar sus proyectos de investigación al CEIC de su Comunidad.

Bases de datos

Afortunadamente ya no estamos en la época en que se almacenaban los datos en cuadernos y fichas y se analizaban con lápiz, papel y calculadoras. Hoy día tenemos la informática a nuestro servicio. Por lo tanto, es de obligado uso en la investigación.

Una base de datos es una colección de una o más tablas (lo deseable es que estén relacionadas) organizadas en filas (cada una de ellas corresponde a un individuo) y por columnas (cada una corresponde a una variable). También se habla de registros cuando nos referimos a los datos almacenados en una fila.

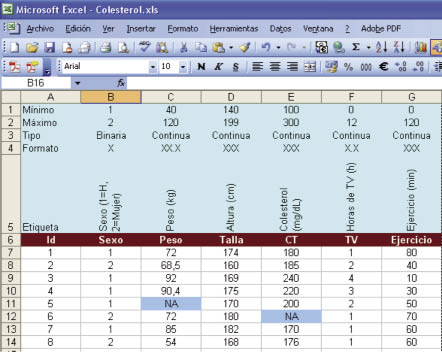

Lo más habitual (y aconsejable) es utilizar una hoja de cálculo (Excel, OpenOffice, etc.). Un sistema algo más avanzado es utilizar un programa específico de base de datos, tipo Access de Microsoft. Es más complejo de manejar, aunque, si tiene experiencia, es una opción más aconsejable. En cualquiera de los dos sistemas se pueden (y deben) implementar sistemas que impidan la introducción de datos erróneos (Figs. 1 y 2).

Aunque existe una tendencia a creer que los datos una vez introducidos en un ordenador son correctos, nada hay más falso. Los datos generalmente contienen errores que deben ser depurados. Esta fase de depuración nunca debe saltarse, de lo contrario hará aparición el síndrome GIGO (garbage input, garbage output). Se dice que dice que de todo el presupuesto dedicado a informática, el dedicado a esta parte (data management) es el que consume más recursos, en tiempo y en dinero.

Un último consejo: ¡haga copias de seguridad con frecuencia!

Herramientas de análisis

Este no es un lugar para explicar detalladamente el fundamento y tipos de pruebas estadísticas, aunque hablaremos algo del “proceso analítico” que se realiza una vez acabado el estudio e introducidos los datos en una base de datos (BdD).

• 1ª fase: exploración de datos. Se debe analizar cada una de las variables y describirla adecuadamente: 1) mediante tablas de distribución de frecuencias (si es cualitativa, ordinal e incluso discreta) y gráficos de barras (olvídese, de una vez por todas, de los gráficos de tarta); y 2) si la variable es numérica deberá calcular una serie de estadísticos de tendencia central (media y mediana), de dispersión (variancia, desviación estándar y rango intercuartílico), de asimetría y “picudez” (curtosis) y sobre todo calcule los cuatro cuartiles e, incluso, más percentiles. Además haga un histograma (mejor de densidad) y sobre todo un boxplot. Finalmente explore si sigue una Ley Normal con la prueba de Shapiro-Wilk (olvídese de la de Kolmogorov-Smirnov). Si la variable no sigue la ley normal plantéese una transformación de datos (inversa, raíz, logaritmo o box-cox). Durante esta fase encontrará errores (siempre existen). Depúrelos acudiendo a los registros originales. Cuando describa porcentajes o medias calcule siempre su intervalo de confianza (IC-95%).

• 2ª fase: análisis de asociación. Habitualmente lo que se pretende en investigación es ver si uno o más factores se asocian con la enfermedad que se está estudiando. Para valorar esta asociación se deben emplear: 1) si las dos variables son cualitativas una prueba de ji-cuadrado; 2) si una variable es numérica y la otra cualitativa con dos categorías deberá hace una prueba de comparación de medias (t de Student) y si tiene más de dos categorías un análisis de la variancia (one-way ANOVA); 3) finalmente si las dos variables son numéricas deberá calcular la correlación y su grado de significación; únicamente en el caso de que fuera significativa podrá calcular una regresión lineal simple y dibujar la recta correspondiente en el gráfico de puntos (scatter-plot). Esta es una explicación muy sencilla, ya que hay más pruebas estadísticas. Estas pruebas referidas sólo deberá ejecutarlas si se cumplen las condiciones de aplicación de las mismas (y si no las recuerda, consulte un libro de estadística o mejor a un experto). Si no se cumplen las condiciones de aplicación deberá realizar las pruebas estadísticas no paramétricas correspondientes (Wilcoxom, Man-Whitney, Kruskal-Wallis, Spearman, etc.).

Esto no acaba aquí, demostrando que hay o no asociación. Lo importante es explorar la fuerza de esa asociación. Esto se calcula con el riesgo relativo (RR) y con lados ratio (OR), siempre con sus intervalos de confianza. Cuántas veces se ven trabajos con análisis incompletos por no haber calculado estos parámetros.

• 3ª fase: análisis multivariable. En ciencias de la salud en muy pocas ocasiones una enfermedad es determinada por un único factor. Hoy día se sabe que influyen múltiples factores. Por tanto no nos tenemos que quedar en un simple análisis bivariable. Se impone la realización de estadística multivariable (regresión lineal múltiple, regresión logística (incondicional, condicional, ordinal, politómica), la regresión de Poisson, la regresión binomial negativa, la regresión de Cox, etc.). Cada técnica exige unas condiciones de aplicación específicas, que si no las domina es mejor que las deje en manos del experto.

Y, por fin, llegamos al punto crucial de: ¿qué programa estadístico utilizar? Hay programas estadísticos, comerciales o no, muy buenos (SAS, Stata, S-PLUS, R, SPSS, NCSS, Minitab, Statgraphics, EpiInfo, etc.). Algunos han desaparecido (BMDP), otros están desapareciendo (S-PLUS), otros acaban de ser comprados y tal vez… (SPSS lo acaba de comprar IBM). Mi consejo personal es que utilice el programa más potente y más actualizado que pueda. Hoy día el que cumple estás condiciones y que además es el que utilizan los propios estadísticos en el diseño de nuevas pruebas estadísticas es el programa R. Es gratuito, se está actualizando constantemente y se puede descargar desde http://cran.r-project.org/. Tiene todas las funciones imaginables que pueda necesitar. Es seguro y muy potente. ¡Úselo!

Conocimientos estadísticos necesarios para informarse e investigar

Para ponerse a investigar hay que tener un bagaje básico de conocimientos sobre metodología de investigación y estadística. No hay que ser un experto metodólogo o estadístico, pero sí conocer el lenguaje que estos manejan, para poderse entender en el obligatorio trato que ha de establecerse.

Cualquiera puede investigar si está suficientemente motivado y desea superar todos los inconvenientes que se le van planteando en su camino. Uno de ellos son los conocimientos en metodología y estadística. Haga cursos para entender el lenguaje epidemiológico-estadístico y póngase en contacto con los expertos en estos temas. ¿Quién se dejaría operar de una simple apendicitis por cualquiera que dispusiera del mejor bisturí del mundo y hubiera acudido a un simple curso de 20-40 horas para aprender su manejo? Nadie en su sano juicio. Por tanto, ¡cuidado con los que presumen de tener una copia de un buen programa estadístico y han hecho un curso de tantas o cuantas horas! En la literatura hay muchos ejemplos de malas estadísticas hechas con buenos programas estadísticos; y entre los médicos hay muchos «aficionados al SPSS». Esto, que puede parecer una crítica negativa, no es tal; simplemente es para indicarle que se introduzca en la investigación, pero haga solamente aquellos cálculos o pruebas estadísticas de las que sea capaz de explicar correctamente sus condiciones de aplicabilidad. De lo contrario, pida ayuda. Se sentirá bien y no le podrán criticar los resultados (o rechazar el artículo cuando lo envíe a una revista para su publicación).

Para finalizar, quisiera acabar diciendo que la investigación es una faceta más (junto con la docencia y la asistencia) que todo pediatra debe realizar. La manera más fácil es haciéndolo en grupo. Únase a personas con intereses afines, elaboren un proyecto y… ¡adelante!

Referencias y lecturas recomendadas

– Bolúmar F, Rebagliato M, Torres AM. Estrategias de diseño en epidemiología. Tipos de estudios. En: Gálvez R, Sierra A, Sáenz MC, Gómez LI, Fernández-Crehuet J, Salleras L, et al. Piédrola Gil. Medicina Preventiva y Salud Pública. 10ª ed. Barcelona: Masson; 2001. p. 79-86.

– Hill AB. The clinical trial. N Engl J Med. 1952; 247: 113-119.

– Cummings SR, Grady D, Hulley SB. Designing an experiment: Clinical Trials I. In: Hulley SB, Cummings SR, Browner WS, Grady D, Hearst N, Newman TB, eds. Designing Clinical Research. Second edition. Philadelphia: Lippincott Williams & Wilkins; 2001. p. 143-155.

– Delgado M. Estudios experimentales. En: Delgado M, Llorca J, eds. Metodología de la Investigación Sanitaria. Barcelona: Signo; 2003.

– Milton JS. Estadística para Biología y Ciencias de la Salud. 3ª ed. Madrid: McGraw-Hill; 2001.

– Armitage P, Berry G. Estadística para la investigación biomédica. 3ª ed. Madrid: Harcourt Brace; 1997.

– Browner WS, Newman TB, Cummings SR, Hulley SB. Preparación para estimar el tamaño de la muestra: hipótesis y principios subyacentes. En: Hulley SB, Cummings SR, eds. Diseño de la investigación clínica. Un enfoque epidemiológico. Barcelona: Doyma; 1993. p. 141-151.

– Bacchetti P, Wolf LE, Segal MR, McCulloch CE. Ethics and Sample Size. Am J Epidemiol. 2005; 161:105-110.

– Jenicek M. Epidemiología: La lógica de la medicina moderna. Barcelona: Masson; 1996.

– Rothman KJ, Greenland S. Precision and validity in epidemiologic studies. In: Rothman KJ, Greenland S, eds. Modern Epidemiology. Philadelphia: Lippincott William & Wilkins; 1998. p. 115-134.

– Colton T. Estadística en Medicina. Barcelona: Salvat; 1979.

– Machin D, Campbell MJ, Tan SB, Tan SH. Simple size tables for clinical studies. 3rd ed. Chichester (UK): Wiley; 2009.

– Chow SC, Shao J, Wang H. Sample size calculations in clinical research. 2nd ed. Boca Raton (FL: USA): Chapman & Hall; 2008.

Lecturas recomendadas

– Hulley SB, Cummings SR, Browner WS, Grady D, Newman TB. Designing Clinical Research. Third edition. Philadelphia: Lippincott Williams & Wilkins; 2007.

– Gallin JI, Ognibene FP. Principles and practice of clinical research. Second edition. Amsterdan: Elsevier; 2007.

– Armitage P, Berry G, Matthews JNS. Statistical methods in medical research. Fourth edition. Massachusetts, USA: Blackwell Science; 2002.